Les indicateurs sont à la mode. Toutes les activités humaines sont maintenant mesurées et quantifiées. Comment “évaluer” le travail des mathématiciens ?

Depuis longtemps, l’activité scientifique en général, et celle des chercheurs en particulier, est évaluée de manière régulière. Par exemple, les chercheurs en mathématiques employés par le CNRS sont évalués par le Comité National de la Recherche Scientifique. Concrètement, une vingtaine de mathématiciens, nommés ou élus pour quatre ans, évaluent le travail de leurs collègues chercheurs.

Devant l’explosion quantitative des publications scientifiques, la tentation est grande de mesurer la qualité d’un laboratoire, ou même d’un chercheur, par des indices calculés de manière automatique. Beaucoup de disciplines scientifiques font un grand usage de ces indices bibliométriques mais la majorité des mathématiciens y sont réticents. Parmi les raisons de cette réticence, on peut évoquer le fait que la communauté mathématique reste de taille raisonnable, même si elle a beaucoup augmenté : le nombre de chercheurs en mathématiques en France est de l’ordre de 4000, dont environ 400 au CNRS. Il reste possible de se comprendre et l’évaluation par des pairs qui connaissent bien les problèmes reste une bonne solution. Une seconde raison est que la « constante de temps » est bien plus grande en mathématiques que dans les autres disciplines : les concepts importants mettent souvent des décennies, et parfois plus, avant d’être reconnus comme tels, si bien qu’un simple décompte des citations par exemple n’est pas un critère approprié.

La discussion de ces questions nécessiterait de longs développements et fera peut-être l’objet de débats dans ce site, mais nous allons nous contenter ici d’un exemple. L’un des indices les plus utilisés pour évaluer la qualité d’une revue scientifique est son « Facteur d’Impact », fondé sur le nombre de citations des articles publiés dans cette revue. Nous allons essayer d’expliquer pourquoi cet indice particulier n’est pas adapté pour les mathématiques.

L’Impact Factor n’est pas adapté aux mathématiques

L’Impact Factor (IF) des revues scientifiques est calculé chaque année par l’Institute of Scientific Information (ISI).

L’IF d’une revue, pour une année donnée N, est le quotient A/B où A est le nombre d’articles publiés pendant l’année N (dans une revue quelconque) qui citent un article de la revue en question publié en N-1 ou N-2, et B est le nombre d’articles de la revue publiés en N-1 ou N-2.

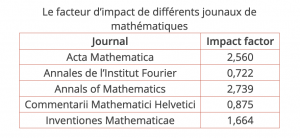

Exemples de quelques revues mathématiques (en 2007) :

.

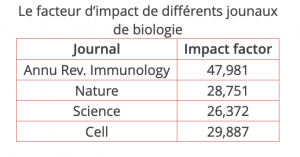

Ces valeurs (pour des revues mathématiques incontestables) sont très différentes de celles atteintes dans d’autres disciplines. Par exemple (pour 2007) :

.

Faut-il en déduire que Science ou Nature sont plus de dix fois plus intéressants que Acta Mathematica ?

Non, bien sûr ☺

Il va de soi que la comparaison des IF entre disciplines différentes n’a pas grand sens comme le montrent les exemples ci-dessus. Elle peut avoir un sens à l’intérieur d’une même discipline, mais le cas des mathématiques demande une attention particulière. Il faut noter tout d’abord que certaines revues mathématiques de tout premier plan sont absentes de la base de données de l’ISI. Mais surtout, l’intervalle de temps de deux ans n’est pas adapté aux mathématiques.

Pour mesurer l’impact d’une revue mathématique, il faut prendre en compte les citations sur une période beaucoup plus longue.

La base de données de Mathematical Reviews de l’American Mathematical Society est un outil plus adapté pour mesurer l’impact des revues mathématiques.

Quelques chiffres

Math Reviews (MR) a indexé (presque) tous les articles mathématiques publiés depuis très longtemps. Par ailleurs, MR a indexé toutes les citations contenues dans les articles publiés depuis 1999 dans une sélection d’environ 300 journaux mathématiques.

La base de donnée contient à ce jour 2 385 808 articles !

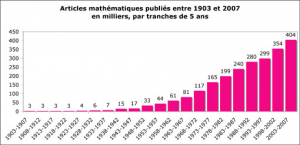

Voici l’évolution du nombre de publications mathématiques depuis le début du vingtième siècle :

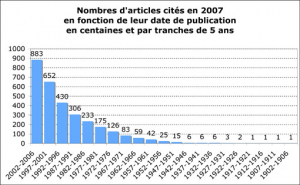

Et voici un graphique qui montre les dates des publications des articles cités en 2007.

Ce graphique surprendra plus d’un non-mathématicien : dans la plupart des autres sciences, les articles sont « démodés » extrêmement rapidement et il n’y a plus de raisons de les citer après quatre ou cinq ans ! Comme on le voit, ce n’est pas du tout le cas en mathématiques. Clairement le calcul de l’IF pour l’année 2007, qui ne prend en compte que les citations d’articles publiés en 2006 et 2005, n’est pas adapté. Bien des articles sont encore lus, utilisés, et cités plusieurs dizaines d’années après leur publication. Pour évaluer une revue mathématique, il faut un recul considérable dans le temps.

S’il fallait un indice : le MCQ plutôt que le IF !

Les Mathematical Reviews ont défini un indice analogue à IF qui utilise cinq années au lieu de deux… L’idéal serait d’utiliser un temps encore plus long, mais les bases de données de citations ne contiennent pour l’instant que cinq années.

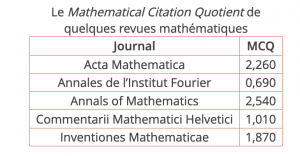

L’indice MCQ (Mathematical Citation Quotient) d’une revue, pour une année donnée N, est le quotient A/B où A est le nombre d’articles publiés (dans la sélection de revues MR) pendant l’année N qui citent un article de la revue en question publié entre N-1 et N-5, et B est le nombre d’articles de la revue publiés entre N-1 et N-5.

Voici quelques chiffres (en 2007) :

.

On peut constater que le MCQ range « en gros » les revues considérées dans le même ordre que le facteur d’impact. S’il ne s’agit que d’évaluer l’intérêt d’une revue, ce genre d’indice a peut-être un sens, mais si on franchissait le pas qui consisterait à évaluer un article (ou son auteur !) en se fondant sur l’IF ou le MCQ du journal dans lequel il est publié, on commettrait une lourde erreur.

Que conclure ?

Les mathématiciens, comme tous les scientifiques, doivent évaluer la qualité de leurs résultats. Ce n’est pas facile et jusqu’à présent, ils font confiance à l’évaluation par leurs pairs, à laquelle ils accordent une très grande importance. Il semble que les indices et les méthodes bibliométriques mises au point pour d’autres disciplines beaucoup plus importantes en nombre de chercheurs, et dont le développement est beaucoup plus rapide, ne sont pas adaptés aux mathématiques.

Récemment, l’Union mondiale des mathématiciens a fait paraître un document sur cette question qui est extrêmement bien documenté et que nous recommandons au lecteur (anglophone).

Cela ne veut pas dire que les mathématiciens ne doivent pas faire confiance aux calculs (ce qui serait un comble pour leur profession !) ; il leur faut réfléchir à la création d’outils adaptés permettant l’évaluation de leurs travaux. Nous avons cité le MCQ, encore primitif, mais on peut en envisager d’autres. Voir par exemple cet article publié dans la Gazette des Mathématiciens qui propose d’autres indices, pas nécessairement convaincants !

La réflexion n’est pas terminée mais espérons tout de même que pendant longtemps encore les mathématiciens seront évalués par d’autres mathématiciens qui lisent leurs articles avant de les noter !

15h24

Il paraît difficile de négligler l’aspect social et politique du principe d’évaluation en mathématiques, en sciences comme ailleurs. Ce qui montrerait la grande versatilité de la nature de ce « principe ».

Et pourtant, l’article présente comme acquis ce principe, comme s’il existait un accord sur ce qui est évalué. On se serait attendu à un peu plus d’esprit critique et pas seulement sur l’aspect technique de tel ou tel indice.

L’article se borne à prendre note : « les indicateurs sont à la mode ». Tiens, et au fait pourquoi ? Ensuite, il revient en arrière : oui, il existe déjà une évaluation par les pairs en maths au cnrs. Puis, seul et dernier point qui a une connotation sociale, une remarque sur la spécificité — la taille ! — de la communauté mathématique française, ce qui permettrait à ses acteurs de relativement mieux se comprendre que leurs confrères membres de communauté plus nombreuses…

On ne peut que rester pantois devant une telle analyse. Il me semble que l’on peut être mathématicien, apprécier (ou non) les travaux des autres et s’interroger plus avant sur les implications de l’évaluation qui est mise en place aujourd’hui. Dommage.

15h49

Merci pour vos commentaires,

Je pense qu’il y a un malentendu. Il n’était pas dans mon intention d’écrire un article sur l’aspect social ou politique de l’évaluation en sciences. J’ai écrit que « La discussion de ces questions nécessiterait de longs développements et fera peut-être l’objet de débats dans ce site, mais nous allons nous contenter ici d’un exemple. » Mon but était simplement de parler d’un indice qui est couramment utilisé en sciences, d’expliquer ce qu’il est, et de discuter de sa signification en maths. Rien de plus.

Oui, cet article se borne à prendre note que « les indicateurs sont à la mode ». C’est un fait, et le but de mon texte n’est pas d’essayer de discuter le « pourquoi ». Une autre fois peut-être je donnerai mon point de vue, mais il n’est pas clair qu’il soit intéressant. J’ai au contraire voulu rester sur un ton factuel et donner quelques indications objectives et quantitatives sur les maths : la taille de la communauté, les habitudes de publications etc. Les lecteurs de ce site ne sont pas des mathématiciens et il me semble que les données contenues dans cet article ne leur sont pas connues. Evidemment, je n’aurais pas écrit le même billet si je m’étais adressé à des mathématiciens.

« seul et dernier point qui a une connotation sociale, une remarque sur la spécificité — la taille ! — » D’abord, ce n’est pas le seul point puisque j’insiste aussi sur le fait que la constante de temps est plus importante en mathématiques. Je maintiens cependant que le fait que la taille de notre communauté soit modeste explique (en partie bien sûr, mais de manière significative) la possibilité d’une évaluation efficace par les pairs. J’ai été moi-même membre du comité national d’évaluation de la recherche et je pense pouvoir dire que s’il y avait disons trois ou quatre fois plus de chercheurs et de labos, le travail d’évaluation deviendrait illusoire et nous serions contraints, comme nos collègues biologistes par exemple, de faire usage d’indices bibliométriques. Oui, je pense que la taille modeste explique la possibilité d’une évaluation par les pairs.

« Il me semble que l’on peut être mathématicien, apprécier (ou non) les travaux des autres et s’interroger plus avant… » Je suis parfaitement d’accord ! bien sûr ! mais comme je l’ai dit plus haut, ce n’était pas le but de cet article, dont le titre est ’Le facteur d’impact en mathématiques » et qui se contente de dire que les indicateurs bibliométriques ne sont pas adaptés pour évaluer des individus. La dernière phrase me semble claire à ce sujet : « espérons tout de même que pendant longtemps encore les mathématiciens seront évalués par d’autres mathématiciens qui lisent leurs articles avant de les noter ! »

16h14

Les revues qu’Etienne compare jouent toutes dans la même catégorie :

revues généralistes de tout premier rang, publiant des articles

conceptuels et difficiles. Cela ne m’avait donc pas trop surpris que

l’impact à deux ans ou celui à 5 ans donnent des résultats similaires,

et que ces indicateurs semblent donc avoir un sens.

J’étais très réticent à utiliser ces indicateurs, et je trouvais de

tres mauvais goût quand un co-auteur insistait sur les critères de

citations pour choisir une revue (cela arrive, surtout si leur

administration prend en compte ces critères pour les promotions).

Je pensais même qu’ils pouvaient être inverse à la qualité : des

petits résultats techniques sont souvent plus faciles à citer que des

pensées profondes. Par contre ils ont a priori une duree de vie plus

courte.

J’esperais mettre cela en évidence par des exemples de revues

specialisées et moins prestigieuses : après une heure a pianotter sur

MatSciNet, rubrique « Journal Citations » et à noter les citations en

fonction des années, j’en arrive malheureusement a constater que mon

opinion personnelle des revues ressemble de très prêt à ce « quotient

de citations », et que pour ce que j’en ai vu, il ne varie pas beaucoup

si on le calcule sur 2 ou 5 ans.

Est-ce que je vais les utiliser moi aussi ? (Ce n’etait sans doute pas le

but d’Etienne !).

Répondre à ce message

20h37

Échelles de temps

Je reste quelque peu sceptique face à l’idée que la recherche en mathématiques se ferait sur une échelle de temps intrinsèquement plus longue que dans les autres disciplines. Plus précisément, je ne conteste pas que la tendance dans les autres sciences (physique, chimie, biologie…) soit de citer des résultats plus récents, mais il me semble que cela tient moins à ces sciences en elles-mêmes qu’aux usages en vigueur chez les chercheurs de ces disciplines.

En effet, la pression mise sur les chercheurs pour qu’ils publient est, me semble-t-il, beaucoup plus forte dans les disciplines que je viens de citer qu’en mathématiques. Or, c’est bien connu, le meilleur moyen de publier un article à coup sûr est de faire un petit pas en avant sur un chemin récemment exploré, le plus vite possible, plutôt que de tenter de défricher en détail un territoire complètement nouveau à l’entrée duquel d’autres se sont cassé les dents trente ans auparavant !

Je connais en tout cas des thèmes de recherches en mathématiques où cette façon de publier se fait : résultats peu intéressants, faisant chacun un tout petit pas dans une nouvelle direction en publiant le plus vite possible, négligeant ce faisant de pousser les idées jusqu’à leur potentiel maximal.

Les indicateurs chiffrés sont précieux et utiles, car ils reposent sur une forme d’objectivité, mais le choix de ces indicateurs est extrêmement délicat et cet aspect tend à être outrageusement négligé par les décideurs. Exemple typique : le classement de Shangaï des universités, qui favorise les grandes structures au détriment des petites. Autre exemple avec les citations : le chercheur qui a eu une idée novatrice sur un certain domaine pourra augmenter artificiellement son facteur d’impact en publiant ses résultats sous forme d’une série d’articles exploitant chacun un aspect de ses idées plutôt qu’en un seul article de fond.

Ainsi, plutôt que de rejeter en bloc les indicateurs, qui de toutes façon seront le seul recours d’un décideur en manque de temps pour rendre un arbitrage, l’enjeu est pour moi de définir un indicateur réellement pertinent, qu’il ne soit pas possible de truquer. Cela dit, je ne prétends nullement connaître de tel indicateur… Y a-t-il un statisticien dans la salle ?

22h57

Échelles de temps

Je pense que tu confonds facteur d’impact, qui s’applique aux revues, et indicateurs de la recherche, qui s’appliquent aux personnes et parfois (très abusivement) aux institutions.

Étienne parlait de facteur d’impact.

Le problème des indicateurs est différent. L’IMU, qui regroupe en particulier des statisticien-ne-s, a émis un rapport intéressant sur le sujet. En français il y a celui de l’INRIA. Car il y a plus que des stats dans le problème, il y a des problèmes de base de données.

Quant à l’échelle de temps, il faudrait sans doute regarder plus en détail. Pour les revues, c’est sûr qu’il y a des différences. Certaines idées émergent en sciences naturelles qui rendent obsolètes les publications antérieures : penser le cerveau comme on le faisait au XIXème siècle est absurde. Utiliser des résultats de Gauss méconnus est encore possible.

Quant aux individus : ce que tu dis est à mon avis un effet induit par les indicateurs et non le contraire. Il suffit de réfléchir à comment améliorer son h-index pour trouver des façons peu orthodoxes. Un indicateur répond à une question précise, du moins essaye. Le détourner, lui faire dire autre chose, l’agglomérer à un autre … tout ça, ça n’a vraiment que peu de sens.

Si un décideur manque de temps, le problème est là, dans le temps ! Pourquoi chercher une façon de faire intelligente à partir d’une méthode idiote ?

Pour obtenir des réponses à des questions, il faut les poser. Aucun sondage ne permet de répondre à des questions qu’il n’a pas posées !

Or aucune donnée bibliométrique ne mesure l’intérêt (au sein d’un paradigme de recherche par exemple), la profondeur d’un résultat ou sa fertilité potentielle.

Ce qu’on mesure en général se limite à un volume de production et à sa visibilité. Rien qui ne soit sérieux pour l’avenir de l’humanité. Tout au plus pour le salaire de quelques uns … Il faut donc savoir sur quoi on veut réfléchir, et si ces indicateurs ont un intérêt.